在本教程中,我们将向您展示如何安装 Apache CentOS 7 上的 Hadoop。对于那些不知道的人, Apache Hadoop 是一个用 Java 编写的用于分布式存储和分发过程的开源软件框架,它通过将数据集分布在计算机集群中来处理非常大的数据集。 库本身不是依靠硬件来提供高可用性,而是旨在检测和处理应用程序层的故障,因此在计算机集群之上提供高可用性服务,每台计算机都可能容易出现故障。

本文假设您至少具备 Linux 的基本知识,知道如何使用 shell,最重要的是,您将网站托管在自己的 VPS 上。 安装非常简单。 我将向您展示分步安装 Apache CentOS 7 上的 Hadoop。

先决条件

- 运行以下操作系统之一的服务器:CentOS 7。

- 建议您使用全新的操作系统安装来防止任何潜在问题。

- 对服务器的 SSH 访问(或者如果您在桌面上,则只需打开终端)。

- 一种

non-root sudo user或访问root user. 我们建议充当non-root sudo user,但是,如果您在充当 root 时不小心,可能会损害您的系统。

安装 Apache CentOS 7 上的 Hadoop

步骤 1. 安装 Java。

由于 Hadoop 是基于 java 的,因此请确保您在系统上安装了 Java JDK。 如果您的系统上没有安装 Java,请先使用以下链接进行安装。

- 在 CentOS 7 上安装 Java JDK 8

[email protected] ~# java -version java version "1.8.0_45" Java(TM) SE Runtime Environment (build 1.8.0_45-b14) Java HotSpot(TM) 64-Bit Server VM (build 25.45-b02, mixed mode)

步骤 2. 安装 Apache Hadoop。

建议创建普通用户来配置apache Hadoop,使用以下命令创建用户:

useradd hadoop passwd hadoop

创建用户后,还需要为自己的账户设置基于密钥的ssh。 为此,请执行以下命令:

su - hadoop ssh-keygen -t rsa cat ~/.ssh/id_rsa.pub >> ~/.ssh/authorized_keys chmod 0600 ~/.ssh/authorized_keys

下载最新的稳定版 Apache Hadoop,在撰写本文时它是 2.7.0 版本:

wget https://www.apache.org/dyn/closer.cgi/hadoop/common/hadoop-2.7.0/hadoop-2.7.0.tar.gz tar xzf hadoop-2.7.0.tar.gz mv hadoop-2.7.0 hadoop

步骤 3. 配置 Apache Hadoop。

设置 Hadoop 使用的环境变量。 编辑 ~/.bashrc 文件并在文件末尾附加以下值:

HADOOP_HOME=/home/hadoop/hadoop HADOOP_INSTALL=$HADOOP_HOME HADOOP_MAPRED_HOME=$HADOOP_HOME HADOOP_COMMON_HOME=$HADOOP_HOME HADOOP_HDFS_HOME=$HADOOP_HOME YARN_HOME=$HADOOP_HOME HADOOP_COMMON_LIB_NATIVE_DIR=$HADOOP_HOME/lib/native PATH=$PATH:$HADOOP_HOME/sbin:$HADOOP_HOME/bin

将环境变量应用于当前正在运行的会话:

source ~/.bashrc

现在编辑 $HADOOP_HOME/etc/hadoop/hadoop-env.sh 文件并设置 JAVA_HOME 环境变量:

JAVA_HOME=/usr/jdk1.8.0_45/

Hadoop 有许多配置文件,需要根据您的 Hadoop 基础架构的要求进行配置。 让我们从基本 Hadoop 单节点集群设置的配置开始:

cd $HADOOP_HOME/etc/hadoop

编辑 core-site.xml:

<configuration> <property> <name>fs.default.name</name> <value>hdfs://localhost:9000</value> </property> </configuration>

编辑 hdfs-site.xml:

<configuration> <property> <name>dfs.replication</name> <value>1</value> </property> <property> <name>dfs.name.dir</name> <value>file:///home/hadoop/hadoopdata/hdfs/namenode</value> </property> <property> <name>dfs.data.dir</name> <value>file:///home/hadoop/hadoopdata/hdfs/datanode</value> </property> </configuration>

编辑 mapred-site.xml:

<configuration> <property> <name>mapreduce.framework.name</name> <value>yarn</value> </property> </configuration>

编辑 yarn-site.xml:

<configuration> <property> <name>yarn.nodemanager.aux-services</name> <value>mapreduce_shuffle</value> </property> </configuration>

现在使用以下命令格式化namenode,不要忘记检查存储目录:

hdfs namenode -format

使用以下命令启动所有 Hadoop 服务:

cd $HADOOP_HOME/sbin/ start-dfs.sh start-yarn.sh

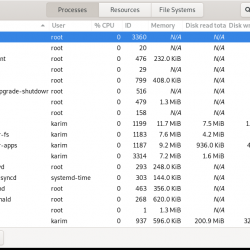

要检查所有服务是否启动良好,请使用’jps‘ 命令:

jps

步骤 4. 访问 Apache Hadoop。

Apache 默认情况下,Hadoop 将在 HTTP 端口 8088 和端口 50070 上可用。 打开您喜欢的浏览器并导航到 https://your-domain.com:50070 或者 https://server-ip:50070. 如果您使用防火墙,请打开端口 8088 和 50070 以启用对控制面板的访问。

现在访问端口 8088 以获取有关集群和所有应用程序的信息:

恭喜! 您已成功安装 Apache Hadoop。 感谢您使用本教程进行安装 Apache CentOS 7 系统上的 Hadoop。 如需更多帮助或有用信息,我们建议您查看 官方 Apache Hadoop网站.